Notre intégration GPU NVIDIA vous permet de monitorer l'état de vos GPU. Cette intégration utilise notre agent d'infrastructure avec l'intégration Flex, qui nous permet d'accéder à l'utilitaire SMI de NVIDIA.

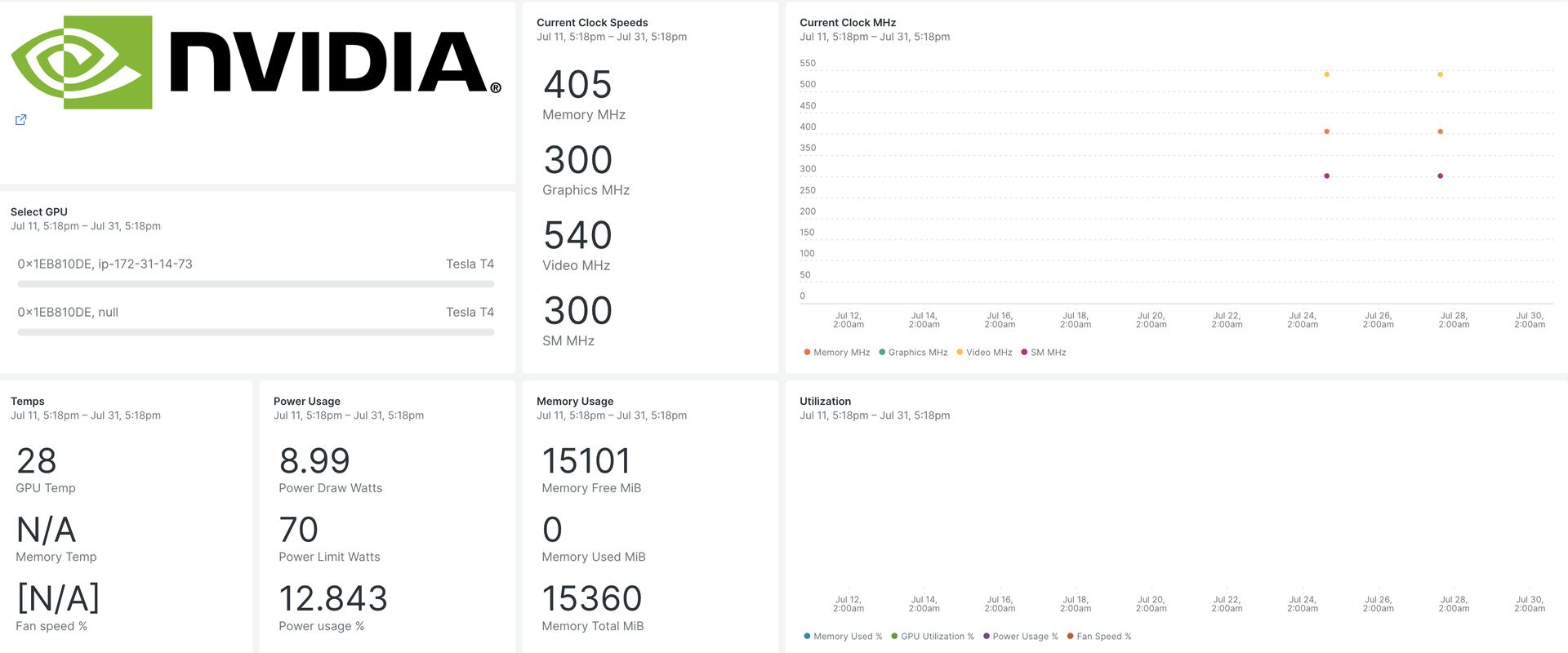

Après avoir configuré notre intégration GPU NVIDIA, nous vous fournissons un dashboard pour vos métriques GPU.

Lors de l'installation, vous obtiendrez un dashboard prédéfini contenant des mesures GPU cruciales :

- Utilisation du GPU

- Nombre d'erreurs ECC

- Processus de calcul actifs

- États d'horloge et de performances

- Température et vitesse du ventilateur

- Informations dynamiques et statiques sur chaque périphérique pris en charge

Installer l' agent d'infrastructure

Pour capturer des données avec New Relic, installez notre agent d'infrastructure. Notre agent d'infrastructure collecte et ingère des données afin que vous puissiez suivre les performances de vos GPU.

Vous pouvez installer l' agent d'infrastructure de deux manières différentes :

- Notre guide d'installation est un outil CLI qui inspecte votre système et installe l'agent d'infrastructure aux côtés de l'agent de monitoring d'application qui fonctionne le mieux pour votre système. Pour en savoir plus sur le fonctionnement de notre guide d'installation, consultez notre aperçu du guide d'installation.

- Si vous préférez installer notre agent d'infrastructure manuellement, vous pouvez suivre un tutoriel d'installation manuelle pour Linux, Windows.

Configurer l'intégration Flex pour les GPU NVIDIA

Flex est fourni avec l'agent New Relic Infrastructure et peut être intégré à NVIDIA SMI, un utilitaire de ligne de commande permettant de monitorer les périphériques GPU NVIDIA.

Important

nvidia-smi est livré préinstallé avec les pilotes d'affichage GPU NVIDIA sur Linux et Windows Server.

Suivez ces étapes pour configurer Flex :

Créez un fichier nommé

nvidia-smi-gpu-monitoring.ymldans ce chemin :bash$sudo touch /etc/newrelic-infra/integrations.d/nvidia-smi-gpu-monitoring.ymlVous pouvez également télécharger depuis le référentiel git.

Mettre à jour le fichier

nvidia-smi-gpu-monitoring.ymlavec la configuration d'intégration :---integrations:- name: nri-flex# interval: 30sconfig:name: NvidiaSMIvariable_store:metrics:"name,driver_version,count,serial,pci.bus_id,pci.domain,pci.bus,\pci.device_id,pci.sub_device_id,pcie.link.gen.current,pcie.link.gen.max,\pcie.link.width.current,pcie.link.width.max,index,display_mode,display_active,\persistence_mode,accounting.mode,accounting.buffer_size,driver_model.current,\driver_model.pending,vbios_version,inforom.img,inforom.oem,inforom.ecc,inforom.pwr,\gom.current,gom.pending,fan.speed,pstate,clocks_throttle_reasons.supported,\clocks_throttle_reasons.gpu_idle,clocks_throttle_reasons.applications_clocks_setting,\clocks_throttle_reasons.sw_power_cap,clocks_throttle_reasons.hw_slowdown,clocks_throttle_reasons.hw_thermal_slowdown,\clocks_throttle_reasons.hw_power_brake_slowdown,clocks_throttle_reasons.sw_thermal_slowdown,\clocks_throttle_reasons.sync_boost,memory.total,memory.used,memory.free,compute_mode,\utilization.gpu,utilization.memory,encoder.stats.sessionCount,encoder.stats.averageFps,\encoder.stats.averageLatency,ecc.mode.current,ecc.mode.pending,ecc.errors.corrected.volatile.device_memory,\ecc.errors.corrected.volatile.dram,ecc.errors.corrected.volatile.register_file,ecc.errors.corrected.volatile.l1_cache,\ecc.errors.corrected.volatile.l2_cache,ecc.errors.corrected.volatile.texture_memory,ecc.errors.corrected.volatile.cbu,\ecc.errors.corrected.volatile.sram,ecc.errors.corrected.volatile.total,ecc.errors.corrected.aggregate.device_memory,\ecc.errors.corrected.aggregate.dram,ecc.errors.corrected.aggregate.register_file,ecc.errors.corrected.aggregate.l1_cache,\ecc.errors.corrected.aggregate.l2_cache,ecc.errors.corrected.aggregate.texture_memory,ecc.errors.corrected.aggregate.cbu,\ecc.errors.corrected.aggregate.sram,ecc.errors.corrected.aggregate.total,ecc.errors.uncorrected.volatile.device_memory,\ecc.errors.uncorrected.volatile.dram,ecc.errors.uncorrected.volatile.register_file,ecc.errors.uncorrected.volatile.l1_cache,\ecc.errors.uncorrected.volatile.l2_cache,ecc.errors.uncorrected.volatile.texture_memory,ecc.errors.uncorrected.volatile.cbu,\ecc.errors.uncorrected.volatile.sram,ecc.errors.uncorrected.volatile.total,ecc.errors.uncorrected.aggregate.device_memory,\ecc.errors.uncorrected.aggregate.dram,ecc.errors.uncorrected.aggregate.register_file,ecc.errors.uncorrected.aggregate.l1_cache,\ecc.errors.uncorrected.aggregate.l2_cache,ecc.errors.uncorrected.aggregate.texture_memory,ecc.errors.uncorrected.aggregate.cbu,\ecc.errors.uncorrected.aggregate.sram,ecc.errors.uncorrected.aggregate.total,retired_pages.single_bit_ecc.count,\retired_pages.double_bit.count,retired_pages.pending,temperature.gpu,temperature.memory,power.management,power.draw,\power.limit,enforced.power.limit,power.default_limit,power.min_limit,power.max_limit,clocks.current.graphics,clocks.current.sm,\clocks.current.memory,clocks.current.video,clocks.applications.graphics,clocks.applications.memory,\clocks.default_applications.graphics,clocks.default_applications.memory,clocks.max.graphics,clocks.max.sm,clocks.max.memory,\mig.mode.current,mig.mode.pending"apis:- name: NvidiaGpucommands:- run: nvidia-smi --query-gpu=${var:metrics} --format=csv # update this if you have an alternate pathoutput: csvrename_keys:" ": """\\[MiB\\]": ".MiB""\\[%\\]": ".percent""\\[W\\]": ".watts""\\[MHz\\]": ".MHz"value_parser:"clocks|power|fan|memory|temp|util|ecc|stats|gom|mig|count|pcie": '\d*\.?\d+''.': '\[N\/A\]|N\/A|Not Active|Disabled|Enabled|Default'

Confirmer que les métriques GPU sont ingérées

La configuration Flex sera automatiquement détectée et exécutée par l'agent d'infrastructure, il n'est pas nécessaire de redémarrer l'agent. Vous pouvez confirmer que les métriques sont ingérées en exécutant cette requête NRQL :

SELECT * FROM NvidiaGpuSampleMonitorer votre application

Vous pouvez utiliser notre modèle dashboard prédéfini pour monitorer vos métriques GPU. Suivez ces étapes :

Allez à one.newrelic.com et cliquez sur Dashboards.

Cliquez sur l'onglet Import dashboard .

Copiez le contenu du fichier (

.json) depuis le dashboard du GPU NVIDIA.Sélectionnez le compte cible où le dashboard doit être importé.

Cliquez sur Import dashboard pour confirmer l'action.

Votre dashboard

NVIDIA GPU Monitoringest considéré comme un dashboard personnalisé et peut être trouvé dans l'UI Dashboards. Pour obtenir des documents sur l'utilisation et la modification du dashboard, consultez notre documentation dashboard .Voici une requête NRQL pour afficher toute la télémétrie disponible :

SELECT * FROM NvidiaGpuSample

Quelle est la prochaine étape ?

Vous pouvez adapter la configuration Flex pour inclure ou exclure des informations disponibles à partir de l'utilitaire NVIDIA SMI.

Pour en savoir plus sur la création de requêtes NRQL et la génération de dashboards, consultez ces documents :

- Introduction au générateur de requêtes pour créer des requêtes basiques et avancées.

- Introduction au dashboard pour personnaliser votre dashboard et effectuer différentes actions.

- Gérez votre dashboard pour ajuster votre mode d'affichage ou pour ajouter plus de contenu à votre dashboard.