Bien OpenTelemetry offre une norme puissante pour la collecte de données d'application générales (trace, métriques, log), il lui manque la capacité de capturer des indicateurs de performances clés (KPI) spécifiques au modèle d'IA. Cela inclut des paramètres cruciaux tels que le nom du modèle, la version, le jeton prompt et de fin, ainsi que les paramètres de température. Ces détails sont essentiels pour monitoring et un dépannage efficaces des performances du modèle d'IA.

OpenLLMetry apparaît comme une solution, spécifiquement conçue pour combler cette lacune dans le modèle d'observabilité de l'IA. Construit sur le framework OpenTelemetry, OpenLLMetry offre une intégration transparente et étend ses capacités. Il offre un support pour les frameworks d'IA populaires comme OpenAI, HuggingFace, Pinecone et LangChain.

Key Benefits of OpenLLMetry:

- Standardized Collection of AI Model KPIs: OpenLLMetry garantit une capture cohérente des mesures essentielles de performance du modèle, permettant une observabilité complète dans divers frameworks.

- Deeper Insights into LLM Applications: Avec son SDK open source, OpenLLMetry vous permet d'acquérir une compréhension approfondie de vos candidatures aux grands modèles de langage (LLM). Cette page décrit les étapes de configuration courantes pour OpenTelemetry APM basée monitoring sur avec New Relic.

OpenLLMetry permet aux développeurs d'exploiter les atouts d'OpenTelemetry tout en acquérant les fonctionnalités supplémentaires requises pour monitoring efficace du modèle d'IA et une optimisation des performances.

Avant de commencer

- Créez un compte New Relic.

- Obtenez la clé de licence pour le compte New Relic auquel vous souhaitez signaler des données.

instrumentez votre modèle LLM avec OpenLLMetry

Étant donné que New Relic prend en charge nativement OpenTelemetry, il vous suffit d'acheminer la trace vers le point de terminaison de New Relic et de définir la clé API :

TRACELOOP_BASE_URL = https://otlp.nr-data.net:443TRACELOOP_HEADERS = "api-key=<YOUR_NEWRELIC_LICENSE_KEY>"- L'exportateur du protocole OpenTelemetry (OTLP) envoie des données au point de terminaison OTLP New Relic.

Example: OpenAI LLM Model with LangChain

from traceloop.sdk import Traceloopimport osimport timefrom langchain_openai import ChatOpenAIfrom traceloop.sdk.decorators import workflow, task

os.environ['OPENAI_API_KEY'] = 'OPENAI_API_KEY'os.environ['TRACELOOP_BASE_URL'] = 'https://otlp.nr-data.net:443'os.environ['TRACELOOP_HEADERS'] = 'api-key=YOUR_NEWRELIC_LICENSE_KEY'

Traceloop.init(app_name="llm-test", disable_batch=True)

def add_prompt_context(): llm = ChatOpenAI( model="gpt-3.5-turbo", temperature=0) chain = llm return chain

def prep_prompt_chain(): return add_prompt_context()

def prompt_question(): chain = prep_prompt_chain() return chain.invoke("explain the business of company Newrelic and it's advantages in a max of 50 words")

if __name__ == "__main__": print(prompt_question())Affichez vos données dans l'interface utilisateur de New Relic

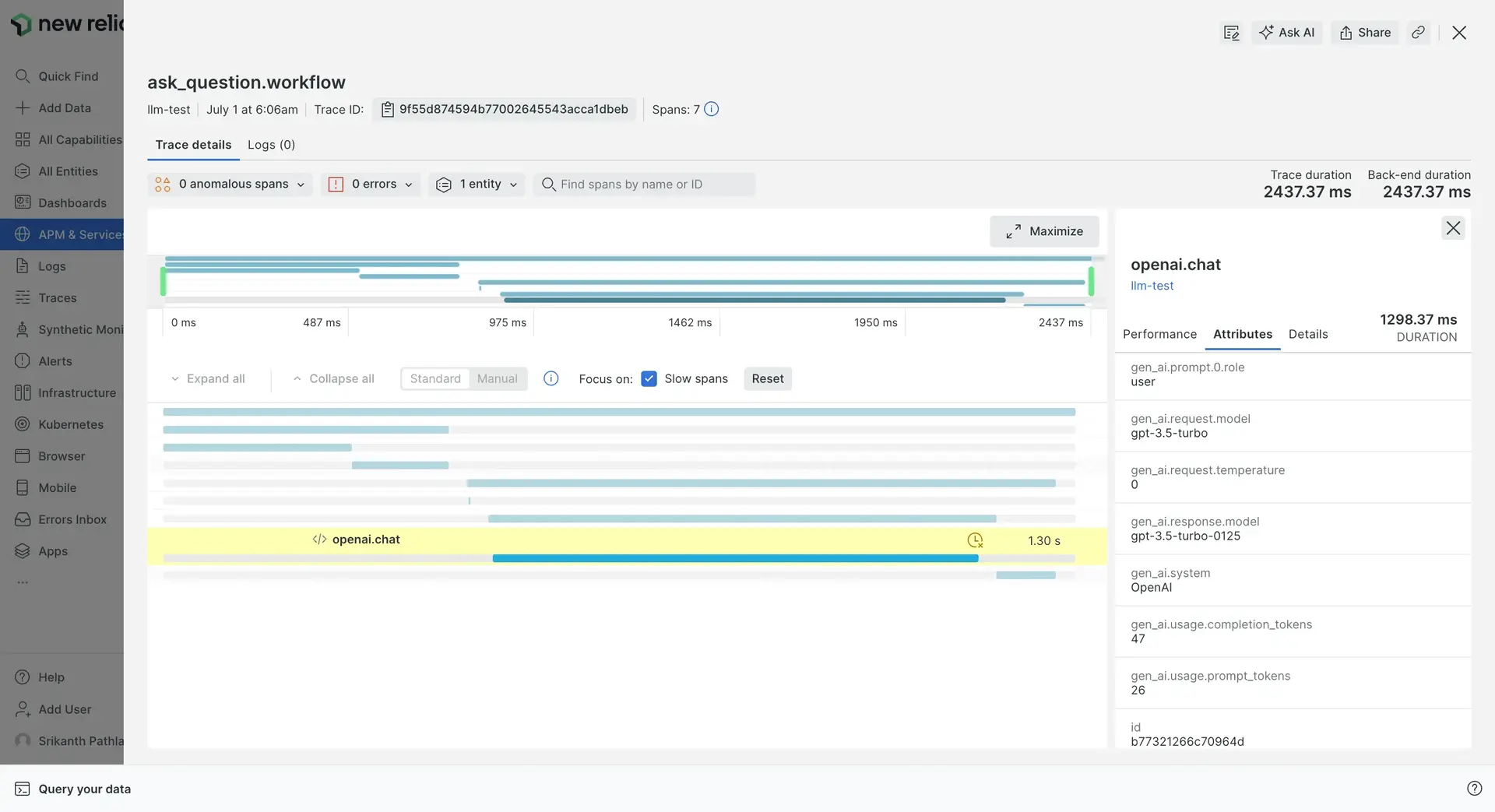

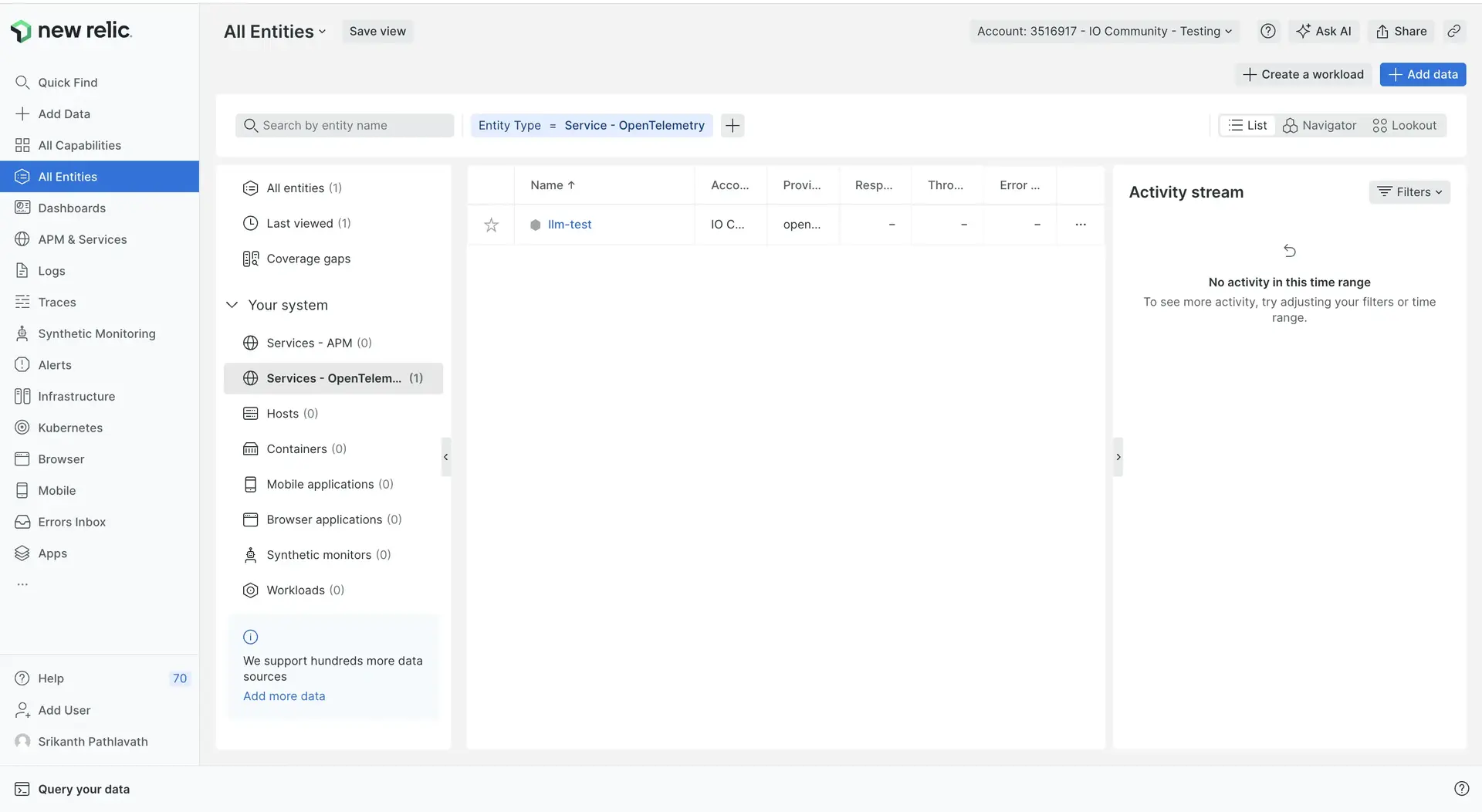

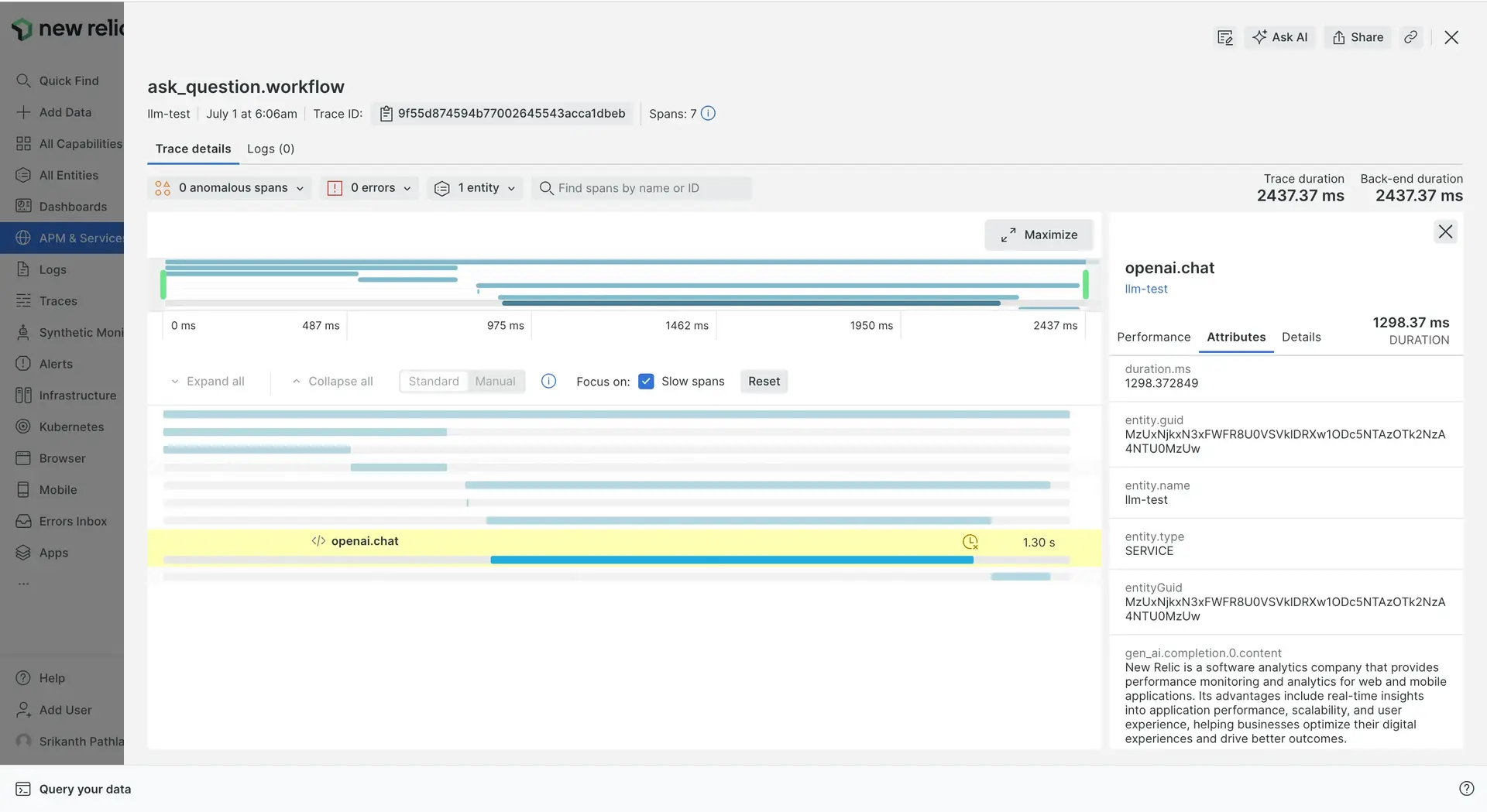

Une fois votre application instrumentée et configurée pour exporter des données vers New Relic, vous devriez pouvoir retrouver vos données dans l'interface utilisateur de New Relic :

Trouvez votre entité à All entities -> Services - OpenTelemetry. Le nom de l’entité est défini sur la valeur de l’attribut de ressource

service.namede l’application. Pour plus d'informations sur la manière dont les entités de service New Relic sont dérivées de l'attribut de ressource OpenTelemetry , voir Services

Utilisez NRQL pour effectuer une requête directement pour trace, métriques et log.

Consultez l'interface utilisateur OpenTelemetry APM pour plus d'informations.

Si vous ne trouvez pas votre entité et ne voyez pas vos données avec NRQL, consultez le dépannage OTLP.

Ce document vous a-t-il aidé lors de votre installation ?